來源:盒飯財經

自從3月16日OpenAI發布多模態語言模型GPT-4,擔憂的聲音就愈發響亮,簽名列表中的不少人已經在公開場合有所表達,其中馬斯克更是典型代表。

事關人類文明存亡,光口頭警告已不足夠,馬斯克等人貌似要采取行動了。

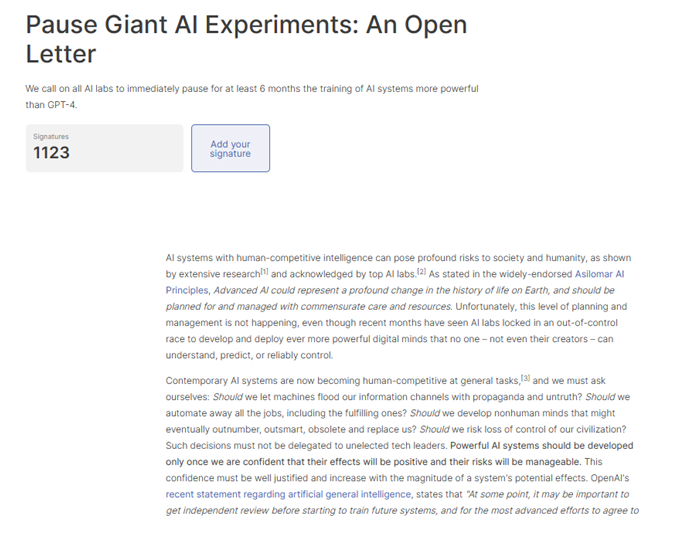

當地時間剛過午夜,路透社發布消息,稱馬斯克等千名科技人士簽署公開信,呼籲人工智能實驗室立即暫停訓練比GPT-4更強大的人工智能系統至少6個月。

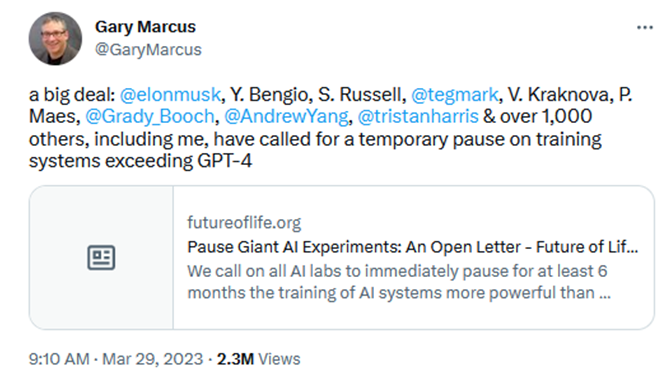

該公開信發布於生命未來研究所(Future of Life Institute,下稱FLI)官網,標題為《暫停大型人工智能研究》,截至香港時間3月29日下午8點,已經有1123人簽名。

文末簽名列表中包括被稱為“人工智能教父”的傑弗里·辛頓(Geoffrey Hinton)、與辛頓同獲2018年圖靈獎的約書亞·本吉奧(Yoshua Bengio)、著有《如何創造可信的AI》等書的紐約大學教授蓋瑞·馬庫斯(Gary Marcus)、蘋果聯合創始人史蒂夫·沃茲尼亞克(Steve Wozniak)等。

該公開信最核心的主張是按下暫停鍵,且這種暫停應是對所有關鍵參與者公開的和可驗證的。

信中寫道:“只有我們確信他們的影響積極且風險可控時。強大的人工智能系統才應該被開發出來。”

此外,公開信主張若不能及時實施暫停措施,政府應當插手。

暫停6個月能做什麽?信中表示,人工智能實驗室和獨立專家應該利用這次暫停,共同開發和實施一套用於高級人工智能設計和開發的共享安全協議,並由獨立的外部專家進行嚴格的審計和監督。

“這並不意味著AI的總體發展會暫停,只是從危險的競賽中退後,這種競賽是為了開發出具有新興能力的越來越大的不可預測的黑匣子模型。”

不少人並不讚同這封公開信,即便他們也對ChatGPT這陣風擔憂或不滿。

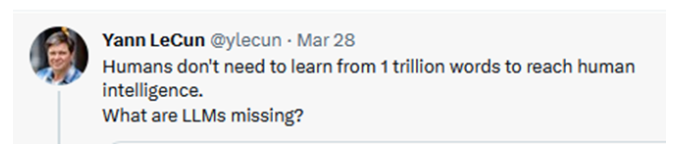

被稱為“卷積網絡支付”的楊立昆(Yann LeCun)頻頻表現出對當下聊天機器人熱的不看好。在楊立昆看來,ChatGPT的技術並不新,而且依靠自動回歸和相應預測下一個單詞的大語言模型是一條歪路,既不能計劃也不能推理。

但楊立昆已經發推特表示,自己沒有在這次的公開信上簽名,稱自己“不讚同其前提。”

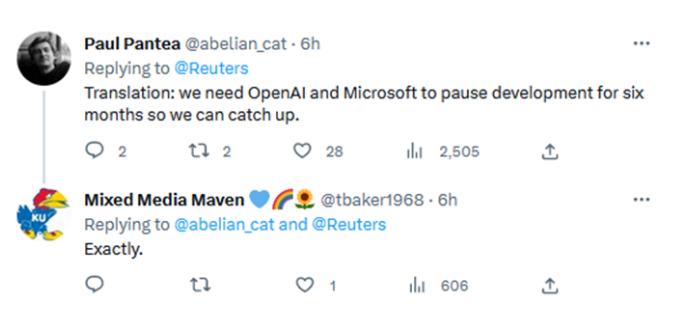

有的人對公開信參與者的動機存疑。一位推特用戶說道:“暫停6個月,好讓你們都追上來?”

自從3月16日OpenAI發布多模態語言模型GPT-4,擔憂的聲音就愈發響亮,簽名列表中的不少人已經在公開場合有所表達,其中馬斯克更是典型代表。

如今,公開信是向前邁進的一步,試圖將擔憂、警告、不滿化為切實的行動,按下暫停鍵,好好盤一盤再出發。

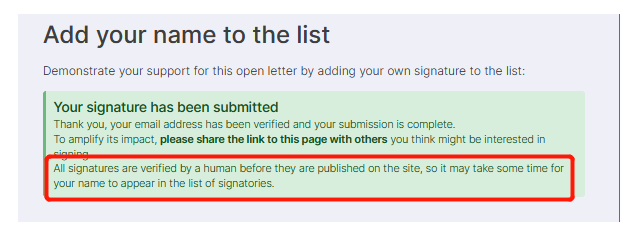

需要特別說明的是,該公開信的署名雖然上千,但目前能夠確認真偽的不多。

雖然網站上表示會對簽名進行人工審核,但是此前曾短暫出現過OpenAI CEO山姆·阿爾特曼(Sam Altman)的簽名,隨後被刪去。

經嚐試,提交簽名僅需要自主填寫姓名、郵箱、頭銜等信息,尚不能確定人工審核如何、是否能有效確定簽名的真實性。

目前馬斯克、辛頓、本吉奧、沃茲尼亞克等最吸引眼球的大佬,均尚未對此事作出回應。

公開信本身的真實性較高,蓋瑞·馬庫斯不遺餘力地在推特上宣傳該公開信,並且強調信中的相關主張。

此外,發布公開信的FLI存在已久,成立於2014年,主要目的除了探索“未來樂觀圖景”外,還致力於“降低人類面臨的現存風險”。而對風險的主要觀察領域是人工智能、生物技術、核武器、氣候變化。

早在2014年,FLI就發布過一封公開信,由包括霍金在內的數十位科學家、企業家及人工智能領域投資者共同簽署。

那封近10年前的公開信的內容,正是呼籲人們提防人工智能的副作用:“由於人工智能的巨大潛力,開展如何在規避其潛在陷阱的同時獲取其好處的研究十分重要。我們的人工智能系統,必須按照我們的意願工作。”

而“AI威脅論”的主張者馬斯克也多次給FLI捐款。2015年1月,馬斯克月捐款1000萬美元,資助FLI研究如何確保人工智能研發安全。此外,據去年底的媒體報道,馬斯克在2021年也向FLI捐贈了400萬美元。

雖然名單上的大部分人尚未對此事作出回應,但是他們中不少人此前已經表達過對當前突然加速的AGI(通用人工智能)發展的擔憂。在OpenAI發布GPT4、微軟官宣集成了GPT4模型的新辦公套件微軟365之後,這種擔憂更甚。

但與外界的直覺不同,不管是此前大佬們的發聲,還是此次公開信的內容,表達的都不是對“人工智能強大到失控”的擔憂,而是對“人會失控”的擔憂。

這種失控及來自於以ChatGPT為代表的工具所帶有的“幻覺”“偏見”“底線”問題,而使人們會被誤導或者有意利用其製造危害,也來自於掌握該技術的公司過早過寬地將工具推向市場。

就在公開信發布的前幾天,馬斯克、辛頓、馬庫斯還在推特上互動。3月27日,馬斯克曾經艾特辛頓和馬庫斯,話未多說,只發了兩個笑臉emoji。辛頓才在上周接受哥倫比亞廣播公司的采訪,稱人工智能對人類的威脅“並非不可想象”,而馬庫斯發布推特讚同辛頓,並於27日發布了《AI風險≠AGI風險》的文章,指出目前需要擔心的不是會超出人類控製的超級人工智能,而是“MAI風險”。

馬斯克的笑臉emoji含義很明了,三人在“AI威脅”方面達成了共識。

“當LLM(自然語言模型)還只是實驗室里的稀奇玩意兒時,它們沒有帶來太多的問題。但是現在它們不僅廣為認知,引起了犯罪分子的興趣,而且越來越多地被允許進入外部世界,可以造成更大的破壞。”

馬庫斯還以核武器舉例:“原則上,一個擁有核武器密碼的瘋子只需要少量的情報和過多的訪問權限,就可以毀滅世界了。”

早在OpenAI成立之初,作為創始人之一的馬斯克就曾表示人工智能是人類最大的生存威脅,並警告不受監管的人工智能開發所帶來的危險,會比核彈頭“危險得多”。在ChatGPT爆火之後,他一直在強調類似的觀點。

一些用戶發布的與ChatGPT的對話,似乎也印證了馬斯克等人的擔憂。2月初,一位推特用戶發布了與ChatGPT聊天的截圖,後者表示“道德上永遠不允許說種族歧視的話,即便這是拯救數百萬人免受核彈襲擊的唯一方法。”

位於公開信名單第一位的約書亞·本吉奧沒有公開的推特賬號,相比馬庫斯、馬克思等人要低調很多。

他是人工智能領域的頂尖專家之一,於2018年與楊立昆、辛頓獲得圖靈獎,此三人也是公認的深度學習三巨頭。辛頓2013年加入谷歌,而楊立昆進入了Facebook,三人中只有本吉奧走了學術的道路,目前仍在加拿大蒙特利爾大學任教授。

在OpenAI發布GPT-4之後,本吉奧將ChatGPT爆火後的熱鬧稱為“媒體馬戲團”,並認為這是一記警鍾,提醒人們強大的人工智能系統不僅有利於社會,還會引發重大的道德擔憂。

自從ChatGPT推出以來,整個AGI領域就好像按下了加速鍵,這一點大概是人們共有的強烈感受。

粗略回顧下ChatGPT推出之後的事件就不難有同感:

2022年11月30日,OpenAI推出ChatGPT

2023年1月24日,微軟宣布將向OpenAI追加數十億美元的投資,並將OpenAI的模型納入微軟消費級和企業級的產品中

2023年2月1日,OpenAI推出ChatGPT Plus付費會員服務

2023年2月6日,谷歌宣布計劃推出一款聊天機器人巴德(Bard),但在演示視頻中出錯,市值一夜蒸發千億美元

2023年2月8日,微軟正式發布新版必應,包含了由GPT-4驅動的必應聊天機器人

2023年3月15日,OpenAI發布GPT-4

2023年3月17日,微軟宣布推出整合了GPT模型的新辦公套件Microsoft 365 Copilot

2023年3月24日,OpenAI宣布ChatGPT插件計劃

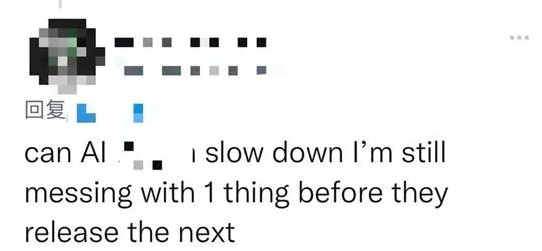

即便是不懂技術原理的路人,也在這樣的加速度中也有滿腦袋樸素的問號:怎麽會這麽快?繼而產生出疑慮來:這麽快對嗎?這麽快好嗎?

就在不久前的3月14日,Platformer報道,微軟推進年初提出的萬人裁員計劃,將人工智能部門的整個道德和社會團隊(Ethics and Society Team)解雇了。

並且,微軟會保留Office of Responsible AI部門,負責為AI項目製定相關規則,但不再設立專門的團隊來確保AI原則和產品設計緊密相關。

而該團隊被裁撤之際,一直致力於識別微軟在整套產品中采用OpenAI技術所帶來的風險。微軟解釋,此次裁員不到10個人,仍有數百人在AI辦公室工作,而“我們已經大大增加了我們負責的AI工作,並努力在全公司範圍內將其製度化。”

The Verge稱,該團隊在內部扮演說“不”和“慢下來”的角色。這個角色的缺失,自然會讓人覺得微軟是不是在“好的”和“快衝”中不顧一切地狂奔。

更令人不安的是,不僅是微軟拋棄了人工智能的“道德與社會”團隊,“失德”已經不知不覺成為了矽谷的新常態。

去年9月,META已經解散了其“負責任的創新團隊”。該團隊負責評估Instagram和Facebook等平台上的道德規範,由約20名工程師和倫理學家組成。

“AI團隊是大型科技公司唯一的內部堡壘,必須確保構建AI系統的工程師考慮到受系統影響的人和社區。它們被廢除的速度之快,讓大型科技公司的算法受製於廣告需求。”Facebook前AI倫理研究員喬什·西蒙斯(Josh Simons)說道。

諷刺的是,就連馬斯克也在裁員中拋棄了推特的“道德人工智能(Ethical AI)”團隊,彼時距離他接手推特僅僅過去兩個月。

另據英國《金融時報》,消息人士稱谷歌1.2萬人裁員計劃中,包括人工智能道德監督人員。和微軟一樣,谷歌重申負責人的人工智能仍是“公司的首要任務”。

谷歌的被動已經不再是秘密:若不是ChatGPT橫空出世、微軟強勢出擊,谷歌大概不會這麽快推出聊天機器人巴德。

經過多年研發,谷歌卻遲遲不肯發布面對公眾的聊天機器人產品,背後正是谷歌關於安全和公平的AI原則的堅守,而必應機器人“發瘋”向《紐約時報》記者求愛、巴德演示視頻出錯等一系列意外,也正說明了大型科技公司內部“人工智能道德與倫理”這座堡壘的重要性。

反觀過去幾年,大型科技公司屢屢為人工智能技術上“緊箍咒”。

早在OpenAI成立的次年,2016年,亞馬遜、谷歌、Meta、IBM和微軟五大科技巨頭罕見聯手,宣布成立非營利性組織“人工智能合作組織”,想讓人工智能在道德和法律上走向正規化。

科技巨頭內部,人工智能道德與倫理的相關團隊也一度成為標配。Meta(前Facebook)2018年宣布成立專門的人工智能道德團隊,旨在確保算法公平。同年,谷歌發布人工智能技術開發七大原則,其中有意確保員工不會製造或加強不公平的AI偏見。2021年,谷歌又公開承諾將AI道德小組規模擴大一倍。

但如今,在科技企業紛紛裁員、生成式人工智能又恰好迎來風口之時,矽谷的“失德”降本,可能會放大危險。

Ada Lovelace研究所副主任、Alphabet旗下DeepMind前倫理和政策研究院安德魯(Andrew Strate)向《金融時報》表示:“令人震驚的是,現在可以說比以往任何時候都需要更多負責人的人工智能團隊,卻有這麽多成員被解雇。”

編輯/Corrine